ستغير ثورة الذكاء الاصطناعي وتطبيقها في مجال الطب والعلوم والاتصالات حياة الناس. وفقاً للخبراء، ستحل الروبوتات محل البشر في مجالات رئيسية، وقد تحررنا من مشاكل اقتصادية وترفع المستوى المعيشي بشكل كبير. سيكون الوصول إلى الإنترنت متاحاً في النظارات والعدسات، وقد يتمكّن الإنسان من التحكم في الأشياء من خلال التفكير، ومع ثورة الطب فإن علاج السرطان والأمراض الجينية، وتجنب الجلطات الدماغية والنوبات القلبية سيصبح ممكناً، بالتالي فإن عمر الإنسان سيطول!

هذه التصورات حول إسقاطات حضور الذكاء الاصطناعي في حياتنا اليوم لا تفرض على الخبراء تحديات وأسئلة تقنية تتعلق بالكيفية والتشغيل فقط، إنما تأتي بأسئلة أخلاقية جديدة تحتّم على الباحثين الوقوف عندها ورسم حدودها وتقييم مخاطرها ومحاولة الإجابة عنها. الأسئلة تتعلق بالقضايا والأزمات الأخلاقية والاجتماعية التي سوف تنتج عن استخدام تقنية الذكاء الاصطناعي بالمجالات المختلفة.

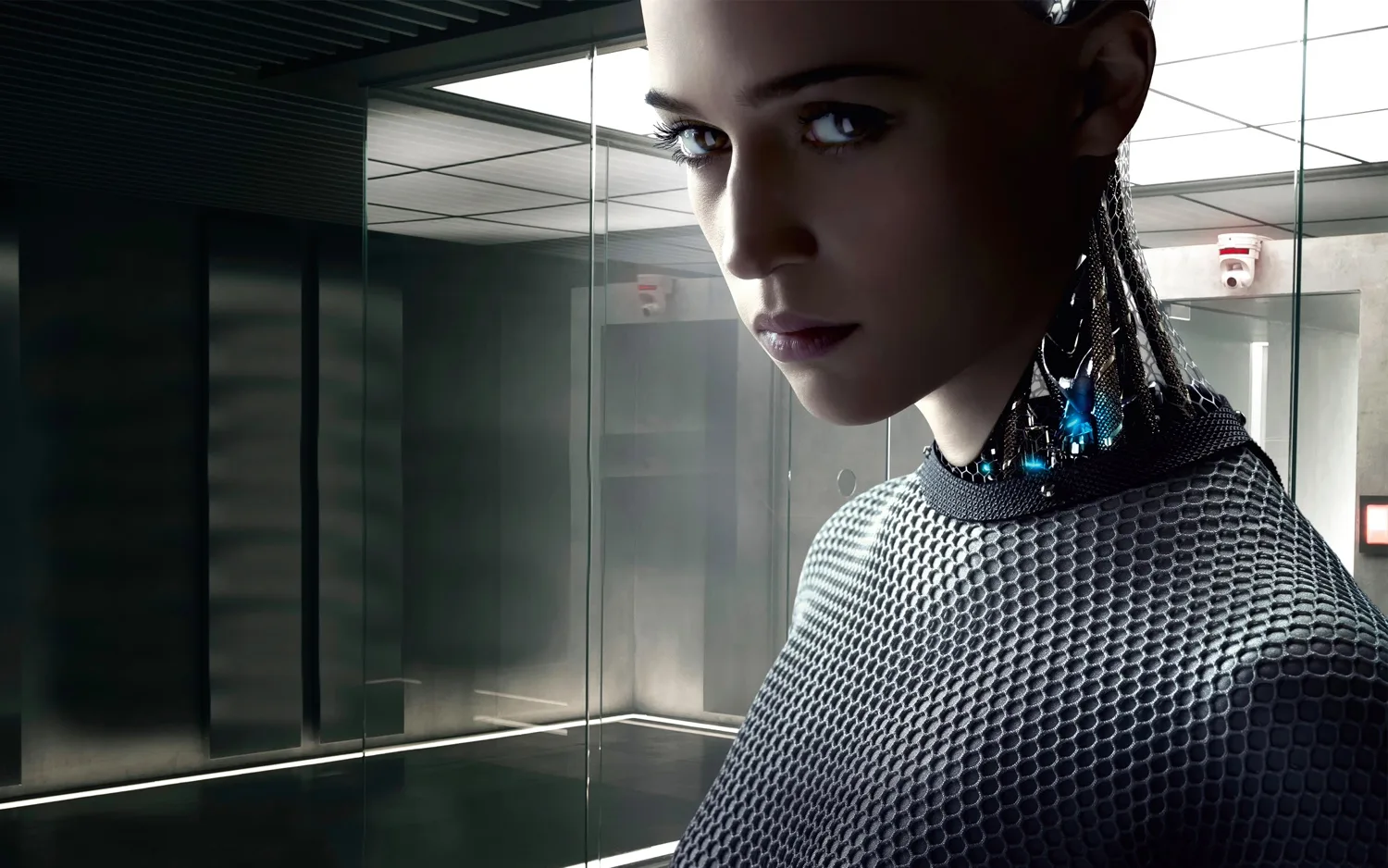

في هذه المقالة نحاول طرح عدد من القضايا الأخلاقية التي قد تقض مضاجع الباحثين بالمجال والمستخدمين المحتَملين، يأتي ذلك بناء على جرد لعدد من الإصدارات البحثية والمقالات التي ناقشت مسألة الأخلاق بنظم الذكاء الاصطناعي. واتضح أن القضايا المختلفة يمكن أن تندرج تحت عنوانين رئيسيين: السيطرة على الآلة وحقوق الآلة.

السيطرة على الآلة

سؤال مركزي: هل ستبّدل الآلة الإنسان؟

يقول روزيلي كاستيلهو، كبير موظفي المعلومات في محكمة العدل التابعة لساو باولو: “مكنتنا أتمتة العمليات لنكون أكثر كفاءة من خلال تقليل الخطوات البيروقراطية، وتقليل عدد الموظفين الذين نحتاجهم للدعم”. جاء ذلك في تصريحه حول الفائدة التي جلبها للمحاكم الأمريكية نظام “مايكروسوفت لإدارة المحاكم” (The Court Management solution)، الذي يعمل على رقمنة النظام القضائي ونقل المحاكم بعيداً عن تقنية المعلومات القديمة والإجراءات الورقية. كما تمكّن قاعات المحاكم الافتراضية من الحصول على شهادات عن بعد وخفض تكاليف السفر وميزات أخرى. كما أن الشركة أطلقت منذ فترة نسخة محدثة من برنامج مايكروسوفت أوفيس (Office 365 Advanced eDiscovery) لمكاتب المحاماة. يجمع البرنامج بيانات ضخمة تخص قضية معينة ويصنفها بحسب أهميتها وفائدتها لملف القضية، ويستثني الملفات غير ذات الصلة. هذه المهمة يقوم بها محامون أو متدربون في مكاتب المحاماة التقليدية، وعليه فإن تعميم هذا البرنامج على القطاع سيقلل الحاجة لتوظيف محامين بشكل كبير.

أن تقوم الآلة بمهام كثيرة عوضاً عن الإنسان سيحوّل موظّفي قطاعات كاملة إلى عاطلين عن العمل بسبب أتمتة الوظائف التي اعتاد الإنسان على أن يقوم بها جسدياً

في مجال الإعلام كذلك، بدأ توظيف الآلات فائقة الذكاء لتقوم بمهام مثل تحرير الأخبار وتلخيص محتوى مرئي عن طريق المونتاج الآلي. فقد ألقت شركة “ناراتيف ساينس” للصحافة الآلية الضوء سابقاً على برنامجها الخاص للذكاء الاصطناعي (Quill) الذي دمج بالفعل في إعداد التقارير لـ “فوربس”، والذي يقوم بالإبلاغ الفوري عن الأحداث الإخبارية العاجلة مثل الزلازل ويقوم بإنتاج قصة بشكل آلي باستخدام الخوارزميات. أن تقوم الآلة بمهام كثيرة عوضاً عن الإنسان سيحوّل موظّفي قطاعات كاملة إلى عاطلين عن العمل بسبب أتمتة الوظائف التي اعتاد الإنسان على أن يقوم بها جسدياً، مما سيزيد الفجوة بين الطبقة العاملة والطبقات المتحكمة برأس المال، لأن الأرباح سوف توزع على عدد أقل من الناس وبالتالي تتعاظم مشكلة عدم المساواة في توزيع الثروات الاقتصادية.

وهنا من الشرعي أن نتساءل حول حدود تطوير التقنية بحيث لا تقضي على أدوار الإنسان جميعها ولا تتسبب بتوسيع الفجوة الاقتصادية بين الطبقات. تجيب جوليا بوسمان على هذه المخاوف قائلة إن أتمتة الوظائف الجسدية ستعود بالفائدة على سوق العمل كونها ستفتح مجالات جديدة وستوفر مساحة للناس للقيام بأدوار أكثر تعقيدًا، والانتقال من العمل الجسدي الذي سيطر على عالم ما قبل الصناعة إلى العمل المعرفي الذي يميز العمل الاستراتيجي والإداري. إلا أن تصوّر بوسمان يمكن محاججته كون هذه التقنيات ستبدل موظفين تراكمت خبراتهم على مرّ السنين لتأدية دور جسدي أو ذهني قابل للاستبدال، وتوظيف قدراتهم في مجال جديد قد يحتاج مراكمة خبرات لم يتعلموها من قبل. وعليه فإن عملية التأهيل ستأخذ وقتاً، أو ربما سيفضل سوق العمل توظيف شباب مواكبين لسوق العمل الناشئ ومتطلباته، مما يترك شريحة الموظفين متوسطي العمر في مأزق.

الغباء الاصطناعي: أخطاء الآلة وإشكالية المحاسبة

يزيد ذكاء الآلة من تعلمها من مدخلاتها، فمع التدريب تبني الآلة أنماطاً للتصرف في مواقف مختلفة. إلا أن التدريب لا يغطي جميع الأمثلة الممكنة التي قد يتعامل معها النظام في العالم الحقيقي، لذلك يمكن أن تترك ثغرات في الآلة تمكّن الإنسان من خداعها بطرق مختلفة. وهنا يلقي بوستروم وزميله الضوء على مشكلة اساسية في الذكاء الاصطناعي، هي أن الأنظمة التي تضاهي قدرة الإنسان أو تتفوق عليه محصورة في نطاقات محددة، وهنا تبرز الحاجة لوجود (AGI) أي (Artificial General Intellegence)- ذكاء اصطناعي شامل، أي الذي يعمل في سياقات متنوعة ومتجددة.

بحسب بوستروم ويودوفسكي، فإن مصطلح “الذكاء الاصطناعي” يشير إلى وجود فضاء تصميم واسع، أوسع من مساحة العقل البشري

في حالة وجود آلة، فإن عدم فهم الآلة للسياق الكامل، أو الجديد، الذي يقصده الإنسان في طلب إنجاز مهمة معينة قد يؤدي لنتيجة غير مرغوبة أو كارثية إن لم تكن مدخلات الآلة كافية وعلى مستوى الدقة المطلوب لتحقيق النتيجة المطلوبة. إذا اعتبرنا أن الآلة عبارة عن جهاز عصبي فيه مستقبلات وناقلات، تحاكي الدماغ البشري، فإن وجود خلل بالبيانات المدخلة أو بالمستقبِلات أو بالناقلات ستسبب خلل بالمعالجة وبالتالي نتيجة خاطئة وربما مضرّة. هنا تبرز قضية أخلاقية: من المسؤول عن خطأ الآلة؟ كيف تتم المحاسبة ومن الضامن لأن يقوم الإنسان بإدخال بيانات دقيقة ومناسبة للنتيجة المرجوة؟

الروبوت العنصري: تحيّز الآلة ومشكلة الشفافية

لا ننسى أن الآلة هي من صنع الإنسان، الذي يمكن أن يكون متحيّزاً أو صاحب أحكام مسبقة، وعليه لا يمكن أن تكون الآلة دائما منصفة ومحايدة. وهو ما قد ينعكس على جودة ودقة الخدمات التي تقدمها وإنصاف القرارات التي تتخذها، فعلى سبيل المثال، يمكن للآلة أن تنحاز ضد أسماء معينة منتشرة وسط مجتمع مهمّش ومنمّط كصاحب دخل منخفض في دولة ما وبالتالي أن ترفض آلياً طلب قرض بنكي قدّمه هذا الشخص. هذا الخطأ وارد، فقد سبق لأن تحيّز برنامج كمبيوتر ينشر نتيجة توقع احتمالية ارتكاب جريمة مستقبلاً ضد ذوي البشرة السوداء وصنّفهم على أن احتمال ارتكابهم للجريمة أكبر. ينتج عن هذه الثغرة أسئلة أخلاقية جديدة، حول مدى دقّة وإنصاف القرارات التي تتخذها الآلة واحتمال تمييزها ضد المستخدم على أساس عرق أو دين، وكيفية فرض رقابة على هذه الآلات. وهنا ينبثق سؤال آخر وهو، من المسؤول عن قرار الآلة إن اتخذت قراراً خاطئاً وما هي آلية المحاسبة؟ وكيف يمكن إثبات مصدر التحيّز وتصحيحه؟ من هنا تبرز ضرورة وجود شفافية، وهو ما تحدث عنه بالتفصيل الباحثان “نِك بوستروم” و “إليعزر يودكوفسكي” في بحث “The Ethics of Artificial Intelligence”، قائلين إن مشكلة الشفافية في عمل الآلة الذكية يجب أن تحل عبر تطوير خوارزميات ذات شفافية وقابلة للتفتيش، ولا يكفي أن تكون قوية وقابلة للقياس فقط، كما أنها يجب أن تكون قوية ضد التلاعب (manipulation) والتوجيه والفساد.

روبوت أذكى من الإنسان!

بحسب بوستروم ويودوفسكي، فإن مصطلح “الذكاء الاصطناعي” يشير إلى وجود فضاء تصميم واسع، أوسع من مساحة العقل البشري (نظراً لأن البشر يتشاركون بنية دماغية موحدة). هذا الفضاء الواسع يعني وجود أعداد كبيرة من التصاميم الممكنة لأنظمة الذكاء الاصطناعي (أدمغة مختلفة)، وبالتالي فإن الإجابة عن سؤال الخير والشر لا يمكن حسمها، وإمكانية سيطرة الإنسان على تصرفات الآلة وتوظيفها لصالحه أو للصالح العام كذلك غير واضحة. فالأمر متعلق بشكل أساسي بتصميم الآلة ومدى ذكائها ومجال عملها وبنيتها وتعامل الإنسان معها.

يقول بوستروم وبودكوفسكي إن القيود الأخلاقية التي نتعرض لها في تعاملاتنا مع أنظمة الذكاء الاصطناعي المعاصرة ترتكز جميعًا على مسؤولياتنا تجاه كائنات أخرى، مثل البشر، وليس في أي واجبات تجاه الأنظمة نفسها

فعلى سبيل المثال، هل يمكن أن يصبح الروبوت فائق الذكاء لدرجة تجعله قادراً على تنبؤ تصرفات الإنسان ضده وبالتالي الدفاع عن نفسه؟

مع ذلك، يرى كورزويل (2005) أنه من المستحيل السيطرة على الذكاء، فعلى الرغم من أي محاولات بشرية لاتخاذ الاحتياطات، إلا أنه، بحكم التعريف، تمتلك الكيانات الذكية الذكاء اللازم لحل المشكلات وتخطي العراقيل التي تواجهها، فجزء من عملية تحسين ذكائها الخاصة أنها تتمتع بإمكانية الوصول دون عوائق إلى شفرة المصدر الخاصة بها: وبالتالي، يمكنها إعادة برمجة نفسها إلى أي شيء تريده. إن تكرار هذه العملية-أي رفع الآلة لذكائها أو سرعة معالجتها- سمّي بـ “انفجار الذكاء” على يد الباحثين الكلاسيكيين في الذكاء الاصطناعي. ومع ذلك، لا يعني هذا أن الآلة الذكية حتماً ستحوّل نفسها لصيغة عدائية.

حقوق الروبوتات

يفرض كل عصر على الإنسان أسئلة أخلاقية وحقوقية غير متوقعة، فعلى الرغم من أن هناك إجماعاً حالياً على أن أنظمة الذكاء الاصطناعي ليس لها وضع أخلاقي، أي أن الإنسان غير مجبر على احترام حقوق الآلة لأنها بالنسبة له ليست مخلوق، إلا أن المستقبل وتطوير ذكاء الآلة قد يغيّر من أساسيات هذا النقاش ويشكّل فريقين، أحدهم يعتبر أن للآلة وضع اخلاقي يجب احترامه والحفاظ عليه كلما اقترب ذكاؤها من ذكاء الإنسان، وآخر يرى في هذه النظم آلات لا تملك مشاعر ولا تشعر بذاتها ولا بالآخرين وبالتالي ليس لها حق أخلاقي على الإنسان.

هنا يقول بوستروم وبودكوفسكي إن القيود الأخلاقية التي نتعرض لها في تعاملاتنا مع أنظمة الذكاء الاصطناعي المعاصرة ترتكز جميعًا على مسؤولياتنا تجاه كائنات أخرى، مثل البشر، وليس في أي واجبات تجاه الأنظمة نفسها. وأن المعيارين المرتبطان بالسؤال الأخلاقي هنا ارتباطاً هاماً هما: الشعور (بالألم مثلاً) والعقل (التفكير والوعي بالذات). هذه المعايير قد تنطبق لاحقاً على نظم فائقة الذكاء، وستتحول بسهولة إلى نقاش قضائي وتشريعي لتقنين التعامل مع هذه الآلات. فرانسيس كام اقترح المعادلة التالية للتعامل مع الوضع الأخلاقي، والذي يضع الآلة في المركز: X لديه وضع أخلاقي = لأن X يعد أخلاقياً في حد ذاته ، فمن المسموح / غير المسموح به القيام بالأشياء من أجله. في حين يرى آخرون أن احترام الآلة نابع من الخدمات التي تقدمها والتسهيلات التي تضفيها على حياة البشر في المجالات المختلفة، خاصة وأن أدوارها المتوقعة قد لا يكون لها بديل بشري في حينه.